L’insostenibile leggerezza dell’essere (digitale) e dell’AI

La grande fuga (dei camici bianchi) e la trasformazione digitale: problema o risorsa? – Verso una digitalizzazione sostenibile in sanità

There has never been a better (and more dangerous) time to be a technologist

Ovvero: “Da grandi poteri, grandi responsabilità” (Ben Parker)

Leggi tutto “There has never been a better (and more dangerous) time to be a technologist”

12 Haiku sull’evoluzione digitale: le api e la maratona (dodicesimo e ultimo Haiku)

FUTUREHEALTH – Intelligenza artificiale e salute mentale, ovvero “Le Tre stimmate di Palmer Eldritch”

La teologia di Zuckerberg e il metaverso in sanità

Haiku sull’evoluzione digitale: la foresta, lo scambio immoto e il metaverso (nono Haiku)

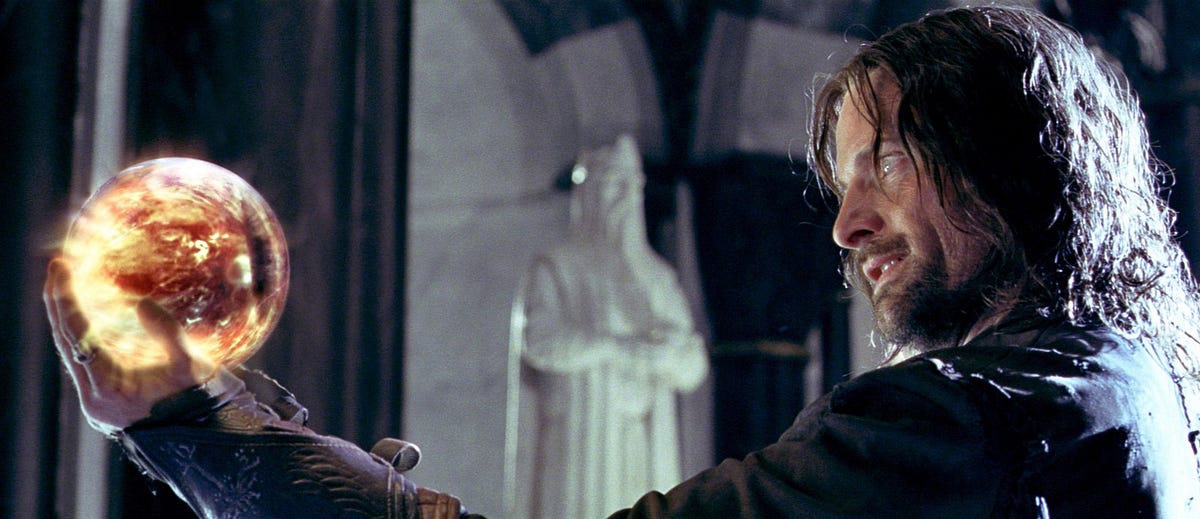

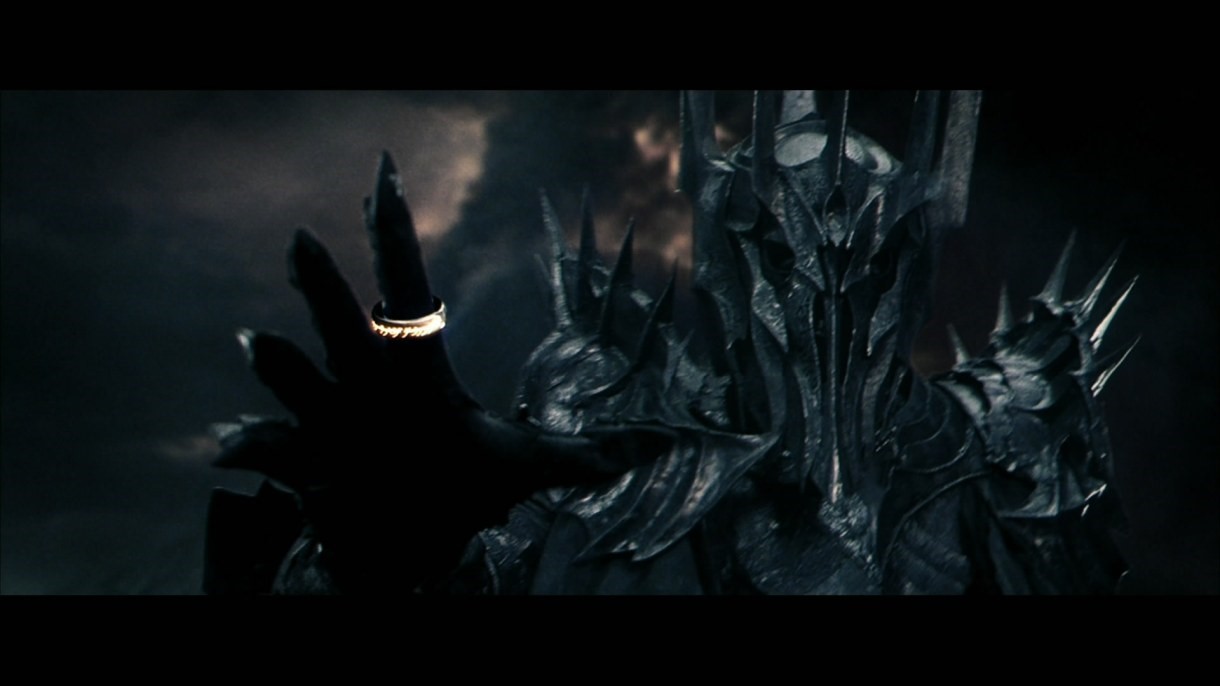

Digital Silk Road: un anello per raggrupparli. Stati o Big Tech il risultato (nefasto) non cambia!

12 Haiku sull’evoluzione digitale: team of teams (ottavo Haiku)

La lezione del “Re di Pietra” sul digitale e sulla vita

Digital Silk Road: un anello per dominarli, ossia perché potremmo diventare tutti uiguri!

12 Haiku sull’evoluzione digitale: diversi uguali (settimo Haiku)

12 Haiku sull’evoluzione digitale: l’attimo fuggente e il feedback continuo (quinto Haiku)

12 Haiku sull’evoluzione digitale: perché servono leader “sobri” per comunicare e collaborare in team complessi (quarto Haiku)

12 Haiku sull’evoluzione digitale: come conciliare visione e obiettivi con un sano empirismo (secondo Haiku)

I paradossi del PNRR e 3 pilastri di una nuova piattaforma culturale: alcune riflessioni e una proposta operativa

To be (agile) or not to be (agile), that is the question – da Shakespeare alle metodologie a supporto dell’evoluzione digitale

La grande bellezza di un obiettivo mancato (ovvero breve riflessione sulla vision e sugli obiettivi agili per evitare forzature e improvvisazioni – anche per l’evoluzione digitale e i fondi del PNRR)

Un girasole di speranza! Ovvero cosa abbiamo imparato sull’evoluzione digitale dagli ospiti di una RSA e da una intraprendente educatrice

Australian Open (Agile Digital Innovation) – Una riflessione su come l’Australia (e in particolare il mondo delle università) sta affrontando la trasformazione digitale

Riflessione sul digitale nelle università australiane