(Articolo pubblicato in anteprima su AgendaDigitale.eu)

Uno scenario preoccupante

In un intervento del luglio 2022 (quindi prima del lancio di ChatGPT) il CTO di AMD, Mark Papermaster, ha proiettato i consumi energetici dei sistemi di Machine Learning ipotizzando addirittura che, nel caso in cui i trend attuali continuassero, supererebbero la produzione mondiale di energia[1]. Lo scenario presentato da Papermaster (nome paradossale per un rappresentante di primo piano del mondo digitale) è certamente contestabile per tante ragioni, ma dovrebbe servire a far scattare almeno qualche campanello di allarme.

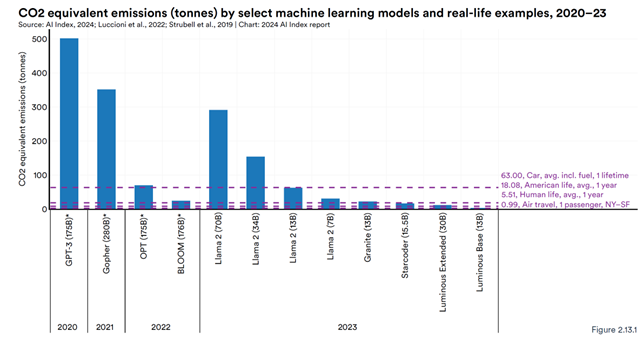

Anche senza arrivare a scenari così catastrofici, vi sono alcuni dati molto eloquenti. Le Intelligenze Artificiali Generative (IAG) sono tremendamente energivore. L’addestramento di ChatGPT3, secondo le stime, avrebbe generato circa 500 tonnellate di carbonio[2], come mostrato da questo grafico estratto dall’AI Index Report 2024 della Stanford University[3]:

Figura 1: impatto ambientale di modelli AI ed esempi di vita reale (in tonnellate di CO2 equivalenti)

In realtà il grafico appena mostrato racconta solo la metà della storia. Infatti, i Large Language Model consumano energia nella fase di training, ma anche nella fase di utilizzo (tecnicamente: inferenza). Quindi, oltre alle tonnellate di carbonio generate nella fase di costruzione e arricchimento dei modelli, dobbiamo considerare anche quelle generate dal loro utilizzo “su strada”. Si stima che generare un’immagine con un’IAG equivalga ad una carica completa di uno smartphone[4]. Se solamente Google spostasse il suo modello di servizio dalle ricerche tradizionali alla ricerca “AI Powered”, il suo consumo energetico arriverebbe a 29.3 Terawatt-ora per anno, equivalente al consumo energetico dell’Irlanda[5].

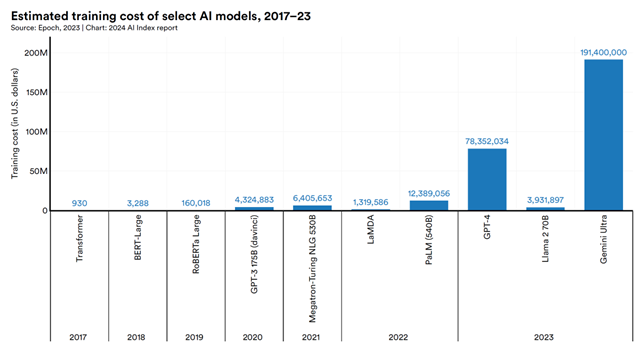

Il costo (che è direttamente correlato al consumo di risorse) del training dei modelli principali di AI Generativa è impressionante, arrivando a oltre 190 milioni di dollari per Gemini Ultra.

Figura 2: costo stimato del training dei diversi modelli (Fonte: Standford AI Index Report 2024)[6]

Forse questi pochi dati possono aiutarci ad avere maggior consapevolezza nell’uso di questi strumenti. Quando “giochiamo” con Dall-e e proviamo a generare immagini per divertimento, stiamo inquinando come se andassimo in giro con una vecchia automobile diesel Euro 0.

I sistemi di Intelligenza Artificiale non sono tutti uguali

Le differenze tra i modelli di intelligenza artificiale, anche dal punto di vista del consumo di risorse, sono enormi. Innanzitutto, ora l’hype è sull’intelligenza generativa, che però è solo uno degli strumenti, ed è usata spesso a sproposito. L’intelligenza generativa ha la capacità di generare per inferenza nuovi contenuti (testo, immagini, ma anche video o musica) a partire da un training iniziale. L’IAG testuale è un grande affabulatore: bravissima a rispondere a qualsiasi domanda, talvolta prendendo però delle cantonate tremende (le cosiddette allucinazioni). Per la prima volta nella storia dell’informatica abbiamo costruito strumenti che privilegiano la fluenza nella produzione di contenuti rispetto alla precisione e all’affidabilità. Questo dovrebbe dare già di per se un’indicazione su quali casi d’uso siano adatti a questi strumenti e quali no. Per avere un panorama più completo, citiamo ne seguito alcuni strumenti di Intelligenza Artificiale non generativa (la lista non è esaustiva):

- Machine Learning tradizionale (non generativo)

- Ottimizzatori, come tutti gli strumenti usati in ambito di ricerca operativa per conciliare obiettivi non convergenti

- Simulatori, usati in ambito predittivo (e.g. meteorologico) e anche per generare dati sintetici usati per allenare le AI generative

- Sistemi a regole, come i vecchi e cari sistemi esperti, che hanno il grande vantaggio della “spiegabilità” dei risultati

- Grafi di conoscenza, usati spesso per sistemi di raccomandazione o motori di ricerca. Oltre ad essere spiegabili, la loro risposta è deterministica.

Spesso quello che succede è che, anche per limitare le famigerate allucinazioni, i modelli vengono mixati. Ad esempio, modelli tradizionali e grafi di conoscenza vengono abbinati a modelli generativi per migliorare la precisione.

Indubbiamente gli strumenti di Intelligenza Artificiale Generativa sono i più energivori di tutti; quindi, la prima domanda da porsi è se ci serva veramente una IAG oppure se non sia meglio (dal punto di vista della sostenibilità, ma spesso anche degli obiettivi) usare uno strumento diverso.

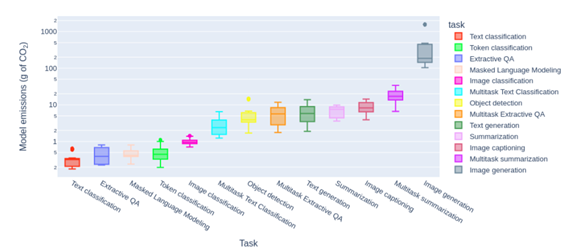

La seconda considerazione, nel caso in cui l’IAG fosse lo strumento corretto, è che anche le IA generative non sono uguali tra loro dal punto di vista del consumo di risorse. Infatti, il consumo dipende da molte variabili, la prima delle quali riguarda il tipo di task che viene assegnato al modello. In generale la classificazione di contenuti è meno onerosa della generazione degli stessi e la generazione di immagini o video più onerosa della generazione di testo.

Figura 3: emissioni di CO2 in base al tipo di task[7]

Un’altra considerazione importante riguarda da distinzione tra modelli generalisti e modelli specialistici. Nello studio già citato[8] (Luccioni 2023), il confronto tra modelli “general purpose” e modelli “single task” o “fine-tuned”, dimostra chiaramente che la capacità di gestire task multipli ha un costo elevato. Infatti, i modelli generalisti hanno un numero di parametri maggiore e un’architettura più complessa, il che si traduce in un costo computazionale e un consumo energetico maggiori sia per la fase di training che di inferenza (generazione di contenuti).

Quindi diventa fondamentale la consapevolezza rispetto ai temi legati alla sostenibilità perché, ogni volta che usiamo un tool di IA o ancora peggio di IAG, stiamo consumando risorse importanti. Nelle nostre scelte aziendali e personali questa consapevolezza è presente? Ormai gli strumenti di AI (generativa e non generativa) sono migliaia e credo sia responsabilità, tanto personale quanto aziendale, usare un discernimento informato nella fase di scelta. Infatti, il costo che paghiamo per l’uso di questi strumenti (che a volte sono addirittura fintamente gratuiti) non tiene in considerazione gli impatti ambientali generati.

Da OpenAI a TransparentAI?

Come si è visto, quello della sostenibilità del digitale è un tema primario e non più eludibile. Come ogni tema complesso, va affrontato su più livelli. C’è un livello normativo, fondamentale. Ad esempio, la California ha emanato delle leggi che impongono alle aziende attive sul loro territorio (incluse OpenAI e Google) di essere più trasparenti rispetto agli impatti ambientali e ai relativi rischi[9]. Lo stesso sta facendo l’Unione Europea[10]. È un primo passo, ma importante. Oltre a questo, c’è il livello di responsabilità sociale e ambientale delle aziende, soprattutto dei grandi “hyperscaler”. Google sta puntando al “net-zero emission” per il 2030. Lo stesso stanno facendo molte altre aziende. Sarà sempre più importante allora la trasparenza dei modelli di AI. Non solo dal punto di vista dell’”explainability” (spesso impossibile per molte architetture), ma anche dal punto di vista della trasparenza sugli impatti ambientali e sul consumo di risorse. Ed oggi non sempre questa trasparenza c’è.

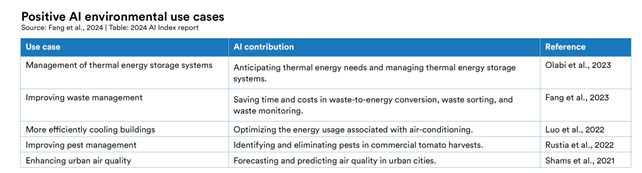

Ma non è tutto. Ci sono almeno altri due aspetti fondamentali. Il primo è quello di sfruttare anche l’altra faccia della medaglia della sostenibilità digitale, ossia il fatto che il digitale possa dare un contributo alla sostenibilità. Gli esempi sono molteplici e per approfondirli un buon punto di partenza è il sito della Fondazione per la Sostenibilità Digitale[11] oppure il già citato AI Index Report di Stanford:

Figura 4: emissioni di CO2 in base al tipo di task[12]

Per finire, un’ultima considerazione: forse siamo in un doppio tunnel cognitivo. Il primo riguarda il fatto che stiamo vivendo un hype esagerato sull’Intelligenza Artificiale Generativa e la stiamo usando spesso a sproposito. Abbiamo insomma la sindrome dell’uomo con il martello, a cui ogni problema sembra un chiodo.

Il secondo tunnel cognitivo riguarda il fatto che chiamiamo “Intelligenza Artificiale” ciò che intelligenza forse non è[13]. Questo ha dei risvolti importanti perché porta ad attribuire a questi strumenti dei poteri eccessivi e delle aspettative non realistiche e genera un bias nella scelta. Ad esempio, io penso che i modelli più generalisti e più complessi siano preferiti non perché ci serva veramente quella complessità, ma perché si avvicinano di più all’intelligenza artificiale come ce la aspettiamo, dandoci la sensazione di dialogare con un’altra persona. Inoltre, usando a sproposito il termine intelligenza, tendiamo a deresponsabilizzarci rispetto alla nostra responsabilità etica nell’uso degli strumenti: dobbiamo essere intelligenti noi, non gi strumenti, per poter governare quelli che sono artefatti che simulano l’intelligenza. Siamo di fronte ad un linguaggio senza pensiero, ad una simulazione di intelligenza senza intelligenza, ad un teatrino della coscienza senza coscienza. Una sorta di “imitation game” alla Turing. Solo che non è un gioco, perché i risvolti sociali, etici e di sostenibilità di questo bias cognitivo determinano la nostra visione del futuro. Ed una visione distorta non può che portare nella direzione sbagliata.

[1] https://semiengineering.com/ai-power-consumption-exploding/

[2] https://www.startmag.it/innovazione/quanto-inquina-lintelligenza-artificiale/

[3] https://aiindex.stanford.edu/report/

[4] https://arxiv.org/pdf/2311.16863.pdf

[5] https://thenextweb.com/news/googles-ai-could-consume-as-much-electricity-as-ireland

[6] https://arxiv.org/pdf/2311.16863.pdf

[7] https://arxiv.org/pdf/2311.16863.pdf

[8] https://arxiv.org/pdf/2311.16863.pdf

[9] https://www.nytimes.com/2023/09/17/climate/california-climate-disclosure-law.html

[10] https://www.reuters.com/sustainability/eu-finalises-new-corporate-sustainability-disclosure-rules-2023-07-31/

[11] https://sostenibilitadigitale.it

[12] https://arxiv.org/pdf/2311.16863.pdf

[13] https://diginomica.com/ai-curve-fitting-not-intelligence